据外媒报道,亚马逊正在完善其致力于服装和其他时尚配饰“Virtual try-on”(虚拟试穿)的工具。亚马逊的人工智能研究人员利用多种算法同时开发了新的功能。

第一种算法允许用户通过指定图像中某些标准(颜色、裁切、大小、图案等)的变化来细化他们的请求。例如,用户可以通过输入例如“较浅的花卉图案”来修改产品。第二种方法是推荐与已经选择的服装或配饰搭配产品的建议,第三种方法是根据用户的选择合成一个模特穿着不同服装或配饰的图像,看看它们是否匹配。

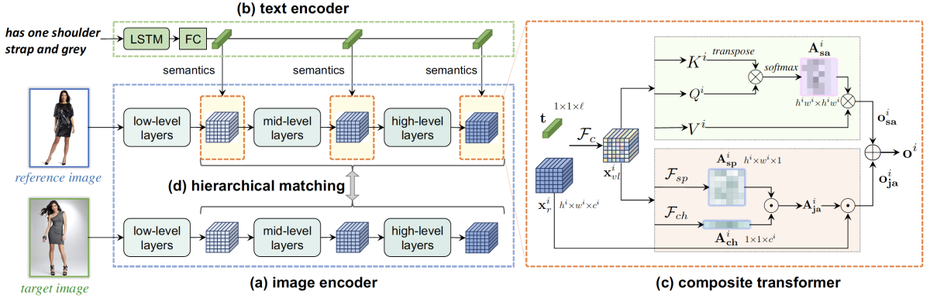

使用文本来优化与产品查询匹配的图像带来了三个主要挑战。首先是找到一种将文本描述和图像特征融合为单个表示的方法。第二个是在不同的分辨率级别上进行融合,客户能够说出抽象的东西,例如“更正式的东西”或精确的“改变脖子的风格”。第三是培训网络以保留某些图像功能,同时按照客户的指示更改其他功能。

为此,亚马逊开发了一个基于三个元素的系统:源图像、文本修订版和与修订版匹配的目标图像。

每个元素由不同的神经元网络并行处理。但是在流水线的三个不同点,源图像的当前表示与文本的当前表示融合在一起,并且融合的表示与目标图像的当前表示相关。每个表示必须支持文本修改。语言和视觉表示的每一次融合都是通过一个由两部分组成的神经网络来完成的。

第一种系统确定了源图像和目标图像中应该相同的视觉特征。第二种系统确定了需要改变的特征。第三个系统叫做Outfit-VITON,它尝试了一种合成服装模特的新方法。研究人员解释说,现有的机器学习系统是由同一件衣服从不同角度拍摄的照片组成的。

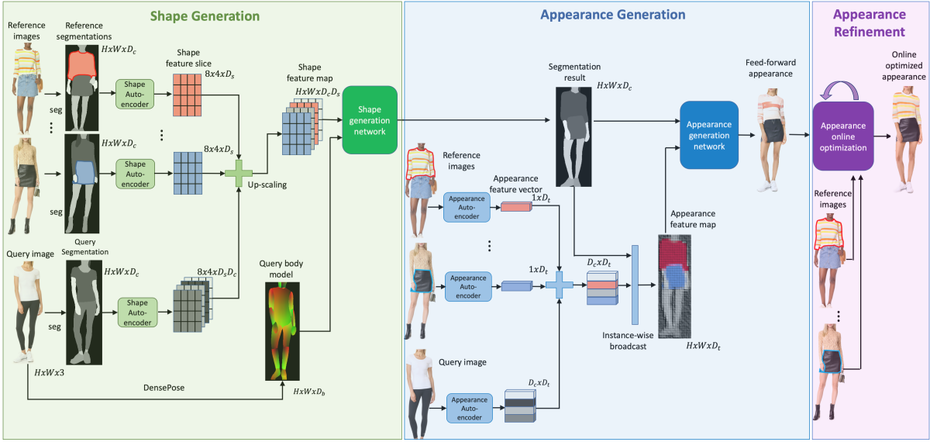

他们的系统使用GANs(生成对抗网络)来根据用户的请求转换单幅图像。此外,它还依赖于用户的测量,以便尽可能准确地表现服装在现实生活中的穿着效果。根据亚马逊的数据,新系统比其性能最佳的前身更容易找到与文本修改有效匹配的58%。

亚马逊使用了一个三步走的过程来合成一张模特穿着不同来源服装的照片。首先是形状生成网络,然后是外观生成网络。第三步是在不改变模型轮廓的情况下,对参数进行细化,以保留某些特征,如徽标或图案。

新系统的输出比以前的系统看起来更自然。在下图中,第一列是查询图像,第二列是参考图像,第三列是性能最佳的先前系统的输出,第四列和第五列是新系统的输出。

近几个月来,虚拟试穿功能越发的成熟。目前最有趣的项目之一是名为SieveNet的神经元网络的使用,其目的是在不影响最终图像质量的情况下,再现一件衣服的特征,包括材料和褶皱。

纺织业受到疫情的严重影响,但这些工具帮助疫情宅家的人们更好地评估一件衣服的实际性能。

对于销售来说,这种功能还可以减少退货的数量,随着在线订单的增加,退货数量呈指数级增长。

(卖家之家/编译:yola)

声明:本文由卖家之家整理和编辑,转载本文不得修改标题及原文,并保留来源以及原文链接,否则我们将保留追索权利。

猜你喜欢

{{comment.user.nickName}} (楼主)

{{comment.time}} 回复({{comment.childAmount}}) 点赞({{comment.voteUpAmount}}) 点赞({{comment.voteUpAmount}})